英伟达近日宣布了一项重大进展,推出了其全新的推理模型套件——OpenReasoning-Nemotron。这一套件内嵌了四个精心构建的模型,它们均基于Qwen-2.5进行微调,参数规模覆盖1.5B至32B不等,源头直指拥有6710亿参数的庞然大物——DeepSeek R1 0528大模型。通过“蒸馏”技术,英伟达成功实现了大模型的轻量化,使得这些推理模型能够在标准游戏电脑上流畅运行,极大地降低了部署门槛,绕开了高昂的GPU与云计算成本。

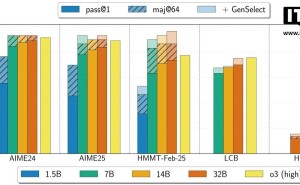

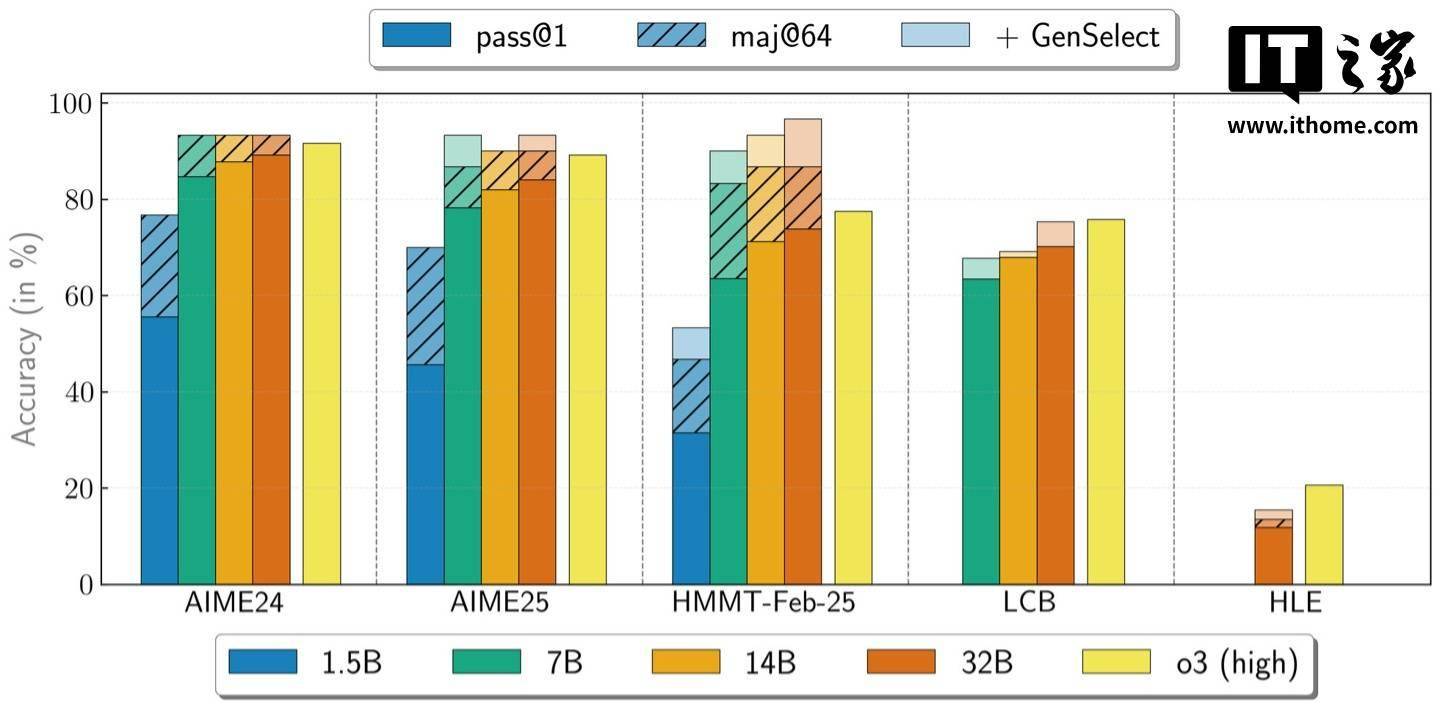

OpenReasoning-Nemotron的核心竞争力并不在于训练技术的突破性创新,而是源于其背后强大的数据支撑。英伟达利用NeMo Skills精心打造了500万个涵盖数学、科学与编程领域的解答数据集,通过纯监督学习的方式对模型进行微调。经过严格测试,32B模型在数学竞赛AIME24中斩获89.2分,在HMMT 2月赛中亦获得73.8分,即便是参数最少的1.5B模型,也分别取得了55.5分和31.5分的佳绩,充分展现了其卓越的推理与解题能力。

英伟达将OpenReasoning-Nemotron定位为科研探索的强大助力,四个模型的完整检查点将在Hugging Face平台开放下载,为研究人员提供了强化学习等进一步实验的坚实基础,同时也便于他们针对特定任务进行定制优化。该模型还支持“GenSelect模式”,即针对每个问题生成多种解答版本,通过筛选最优解来进一步提升准确率。在这一模式下,32B模型在多项数学与编程基准测试中,表现甚至超越了OpenAI的o3-high水平。

尤为英伟达在训练这些模型时,全程未引入强化学习,仅采用监督微调的方式,为社区提供了一个干净且技术前沿的起点,为未来的强化学习相关研究开辟了广阔空间。对于拥有高性能游戏GPU的玩家及个人开发者而言,这套模型无疑是一个巨大的福音,使他们能够在本地运行接近业界最先进水平的推理模型,极大地推动了推理技术的发展与普及。