近日,人工智能领域迎来一项创新成果——DeepSeek团队推出名为DeepSeek-OCR的模型,通过“上下文光学压缩”技术,为大语言模型处理长文档提供了高效解决方案。该模型突破了传统方法对算力和内存的高依赖,为海量文档处理场景开辟了新路径。

当前,大语言模型在处理数千字甚至更长的文本时,计算量呈指数级增长,导致算力成本飙升,成为制约其应用的关键瓶颈。DeepSeek团队从人类视觉系统获取灵感:人类阅读文档时,视觉系统能快速捕捉页面布局、段落结构等关键信息,并进行高效压缩。基于此,团队提出“视觉预处理”思路——将文本渲染为图像,通过视觉模型压缩后,再交由语言模型处理,从而大幅减少输入token数量。

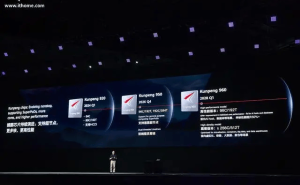

DeepSeek-OCR的核心架构由两部分组成:DeepEncoder(深度编码器)和基于混合专家模型(MoE)的解码器。其中,DeepEncoder融合了SAM(Segment Anything Model)和CLIP(Contrastive Language–Image Pre-training)两种视觉模型架构。SAM擅长处理局部细节,通过窗口注意力机制捕捉分散的视觉特征;CLIP则依赖全局注意力机制,提取整体知识信息。两者通过16倍下采样的卷积模块衔接,形成“先局部后全局”的处理流程,有效解决了高分辨率图像处理中的内存溢出和token爆炸问题。

解码端采用DeepSeek自研的30亿参数混合专家模型,激活参数为5.7亿。该模型通过动态分配任务至不同专家网络,在保持规模可控的同时,实现了强大的文本还原能力。实验表明,在处理600至1,300个文本token的英文文档时,DeepSeek-OCR仅需64或100个视觉token即可完成处理。当压缩比低于10倍时,OCR解码精度达97%以上;即使压缩比达20倍,准确率仍维持在60%左右。

在OmniDocBench等实际应用场景测试中,DeepSeek-OCR的表现优于同类模型。例如,相较于GOT-OCR2.0(每页256个token)和MinerU2.0(每页超6000个token),DeepSeek-OCR以更少的视觉token达到了业界先进水平。模型通过训练包含图表、化学分子式、几何图形等多样化数据,具备了深度解析能力。例如,它能将报告中的图表转换为表格数据,将化学文献中的分子式输出为SMILES格式,甚至解析几何图形中的线段关系,为金融、科研、教育等领域提供了新的工具。

目前,DeepSeek已开源该模型的核心代码和权重。据技术报告披露,在生产环境中,单张A100-40G GPU每日可处理超20万页文档数据。不过,模型仍存在局限:当压缩比超过10倍时,性能会因信息损失或图像分辨率降低而下降;在处理极端复杂版面时,解析能力有待提升。OCR任务与多轮对话理解存在本质差异,前者侧重感知和解码,后者涉及推理、记忆检索等复杂认知过程。技术报告指出,未来计划开展数字文本与光学文本交错的预训练实验,并评估长上下文检索的准确性。

尽管如此,DeepSeek-OCR为视觉与语言模态的融合提供了新思路。传统方法通常将两者作为独立输入处理,而该模型表明,视觉与语言可互为信息压缩和解压的媒介。基于这一范式,未来或可探索将多轮对话历史渲染为图像,以更低成本管理更长的对话;或将海量知识库压缩为视觉索引,提升知识检索效率。