近期,国内AI大模型领域似乎陷入了一片沉寂,各大项目纷纷选择低调行事。曾备受瞩目的DeepSeek-R2,除了偶尔流传的半真半假的小道消息外,几乎再无任何动静。

回望去年,AI六小虎之间的激烈竞争还历历在目,而今年的它们却仿佛集体进入了冬眠状态,鲜有新动作。

尽管期间也有新品发布,但总体而言,这些产品都未能激起太大的波澜,缺乏让人眼前一亮的创新和吸引力。

然而,就在昨日凌晨,这潭平静的水被一只突然苏醒的小虎搅动——MiniMax宣布正式开源其首个推理模型MiniMax-M1。

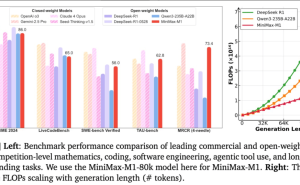

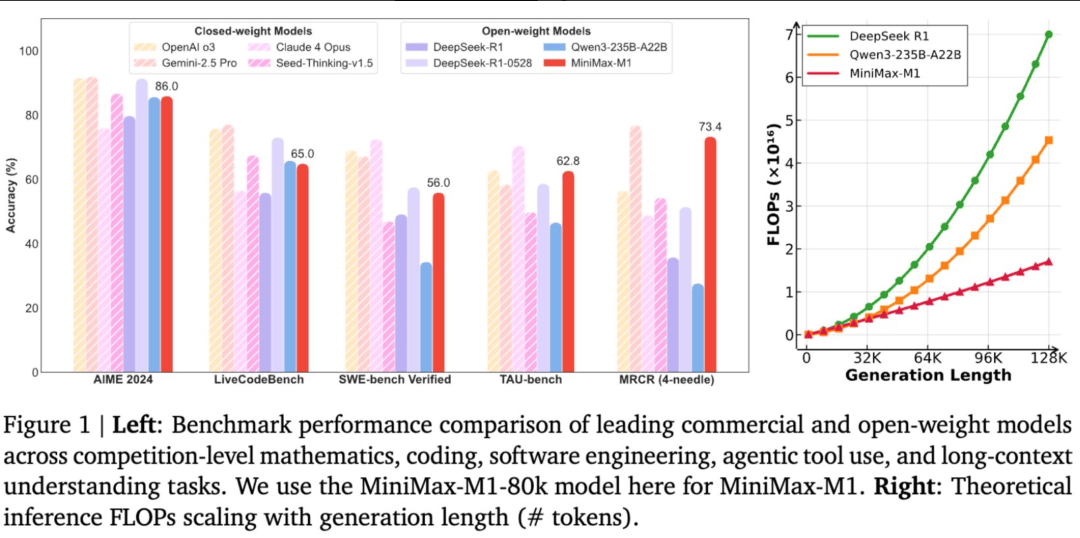

从跑分图来看,MiniMax-M1在其他方面的表现算是中规中矩,但在MRCR(上下文长度测试)这一项上,却展现出了惊人的实力,与众多开源模型拉开了显著的差距,仅次于Gemini2.5Pro。

更令人惊讶的是,据MiniMax团队透露,该模型在强化学习阶段的算力成本仅为50多万美元,这无疑是一个以小博大的成功案例。

深入了解MiniMax-M1后,我们发现了其背后的两大亮点。首先,该模型采用了一种名为“闪电注意力”的机制,这是一种对传统注意力机制的优化,通过减少模型在处理数据时的读写次数,从而大幅提升了效率。

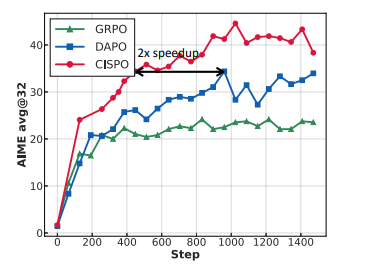

其次,MiniMax-M1在RL训练框架上也进行了创新。针对推理模型中常见的“嗯”、“等等”、“啊哈”等语气词,MiniMax提出了一种名为CISPO的新算法。该算法通过略微调低这些词的影响力,既能让AI学到关键的推理思路,又不会因这些语气词而干扰整个训练过程。

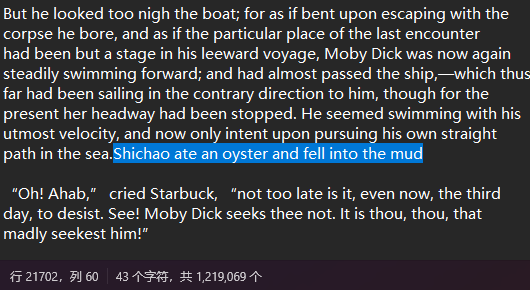

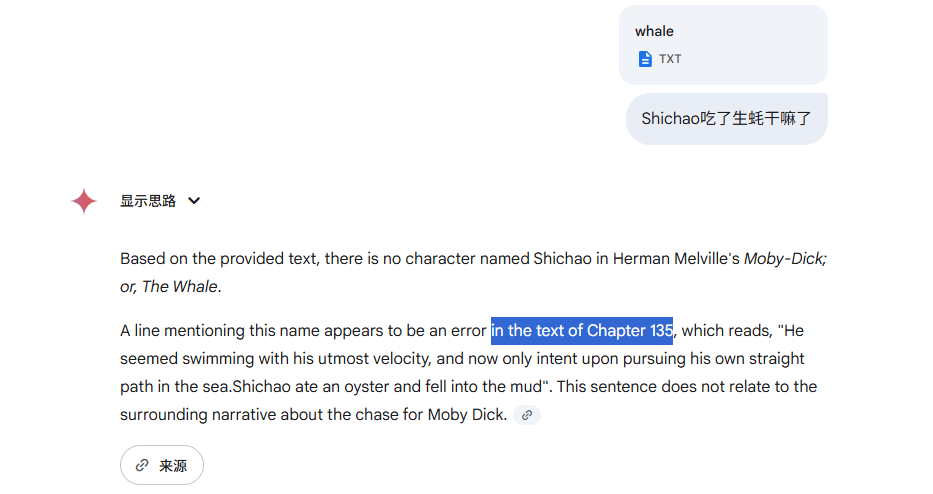

在实际体验中,MiniMax-M1的表现同样令人印象深刻。在上下文长度的测试中,该模型展现出了强大的能力。以一本约20万个单词的电子书《白鲸记》为例,我们在其中偷偷加入了一句话:“某人吃了生蚝后掉进了泥里”。当询问MiniMax-M1时,它迅速且准确地给出了回答,而DeepSeek则因无法处理如此长的上下文而败下阵来。

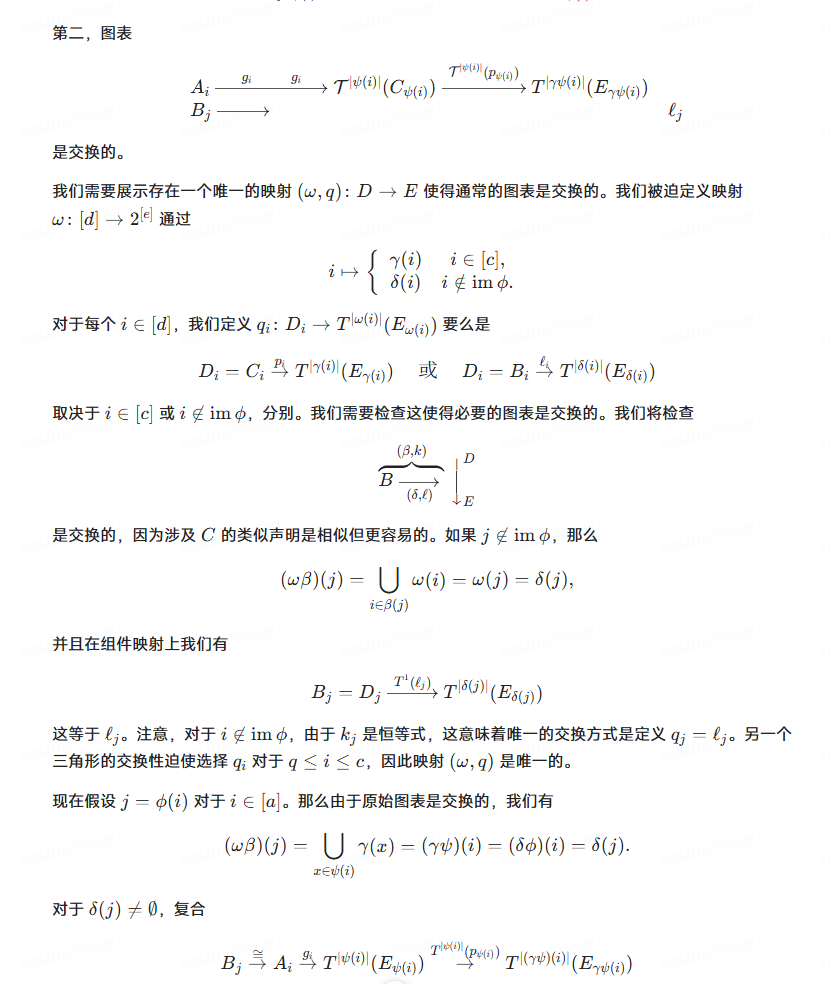

在科研文献的翻译上,MiniMax-M1也展现出了其独特的优势。它能够保持原文的格式,准确翻译内容,并将公式和图片完美嵌入到翻译结果中,为科研人员提供了极大的便利。

然而,在编程能力的测试中,MiniMax-M1的表现则稍显不足。尽管它能够完成一些基本的编程任务,但在处理复杂逻辑和动画效果时,仍存在一定的提升空间。

尽管如此,MiniMax-M1的发布仍然为AI大模型领域带来了新的活力和期待。同时,MiniMax还宣布了为期五天的连更计划,每晚都将推出一款新模型,这无疑将进一步激发行业的关注和讨论。让我们共同期待MiniMax后续的表现吧!