近期,科技界围绕苹果公司一篇关于人工智能的论文展开了激烈讨论。这篇题为《思维的错觉》的论文,由苹果公司于6月6日发布,迅速引起了专家们的关注与争议。

论文中,苹果公司提出一个核心观点:即便是目前最顶尖的大型推理模型(LRMs),在面对复杂任务时也会遭遇崩溃。然而,这一结论随即遭到了Open Philanthropy研究员Alex Lawsen的有力反驳。Lawsen认为,苹果的结论更多地反映了实验设计的瑕疵,而非模型推理能力的固有缺陷。

争议的核心聚焦于苹果论文中的一个具体案例:即便是最先进的大型推理模型,在处理如汉诺塔问题这样的复杂递归算法任务时,也会彻底失败。汉诺塔问题是一个经典问题,要求将一系列大小不同的圆盘从一个柱子移动到另一个柱子,且需遵循特定规则。

针对这一观点,Alex Lawsen撰写了一篇题为《思维错觉的错觉》的反驳文章。他指出,苹果的研究混淆了输出限制和评估设置的问题,从而得出了误导性的结论。Lawsen详细列举了三大问题来挑战苹果的结论。

首先,Lawsen强调苹果忽略了模型的Token预算限制。在处理超过8个圆盘的汉诺塔问题时,一些模型如Anthropic的Claude Opus,已接近其输出极限,甚至因节省Token而停止输出。其次,苹果的过河测试中包含了一些无解谜题,模型因拒绝解答而被判定为失败,这显然是不公平的。最后,苹果的自动化评估脚本过于僵化,仅将完整步骤列表视为成功标准,未能区分推理失败与输出截断,导致部分策略性输出被误判。

为了证明自己的观点,Lawsen重新设计了汉诺塔测试,要求模型生成递归Lua函数来打印解法,而非逐一列出步骤。结果令人震惊:Claude、Gemini和OpenAI的o3模型均能正确生成15个圆盘问题的算法解法,远超苹果报告中“零成功”的复杂性界限。

Lawsen还指出,在去除人为输出限制后,LRMs展现出了处理高复杂任务的推理能力,至少在算法生成层面是如此。这表明,问题可能并不在于模型本身,而在于评估方式。这一发现无疑为人工智能领域带来了新的思考和启示。

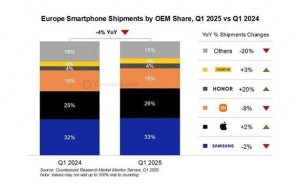

为了更直观地展示其观点,Lawsen还提供了其他测试结果的对比图,进一步证明了其论点的合理性。

此次争议不仅揭示了人工智能研究中的复杂性和挑战,也再次强调了科学评估方法的重要性。随着人工智能技术的不断发展,如何更准确地评估模型的推理能力,将成为未来研究的重要方向。